Der Screaming Frog SEO Spider ist eines der mächtigsten Scraper auf dem Markt. Mit ihm können große Websites gecrawlt und tiefgründig analysiert werden. Er bietet umfassende Konfigurationsmöglichkeiten und Segmentierungen, Schnittstellen zu GA4, GSC, PageSpeed Insights, Ahrefs, Majestic und Moz.

Inhaltsverzeichnis

- Was ist Screaming Frog SEO Spider?

- Screaming Frog Bewertung

- Woher hat der Screaming Frog seinen Namen?

- Was macht Screaming Frog besonders gut?

- Was sind die Nachteile vom Screaming Frog?

- Funktionsumfang vom Screaming Frog

- Zielgruppen

- Screaming Frog Modi

- SEO Spider Konfiguration

- Probleme-Protokoll

- Visualisierungen: Crawlbaumgraph

- Berichte exportieren

- Massenexport

- 🔥 Screaming Frog Anwendungstipps

- Screaming Frog Alternativen

Was ist Screaming Frog SEO Spider?

Eine Lizenz pro Nutzer kostet 239,00 EUR pro Jahr. Sie entsperrt alle Funktionen und hebt das Crawl-Limit von 500 URLs auf. Werden mehrere Lizenzen gekauft, wird Rabatt gewährt.

Screaming Frog Bewertung

| Gesamt | 4.5/5 | |

| Benutzerfreundlichkeit | 3.5/5 | |

| Funktionsumfang | 5/5 | |

| Dokumentation (FAQ) | 4/5 | |

| Preis-Leistungs-Verhältnis | 5/5 | |

| Empfehlungswahrscheinlichkeit | 5/5 |

Woher hat der Screaming Frog seinen Namen?

Der Name Screaming Frog wurde von einem echten Frosch 🐸 inspiriert, der sich wehrte, nachdem er von zwei Katzen in Dan Sharps (Mitbegründer von Screaming Frog) Garten in die Enge getrieben wurde. Hier gibt es die komplette Story.

Was macht Screaming Frog besonders gut?

Der größte Vorteil vom Screaming Frog ist sein Funktionsumfang. Er ist aus meiner Sicht der beste SEO Crawler, um große Websites (+500.000 Seiten) vollständig zu analysieren.

- Umfangreiche Crawl-Konfiguration

- JavaScript-Crawling und -Rendering

- API-Zugang zu anderen Diensten: Google Universal Analytics, Google Analytics 4, Google Search Console, PageSpeed Insights, Ahrefs, Majestic, Ahrefs, Moz, OpenAI, Gemini, Ollama

- Scheduling: Crawls automatisiert planen und durchführen

- Crawling geschützter Bereiche mit Authentifizierung (Standard- oder Formularbasiert)

- Crawl-Berichte in Looker Studio automatisieren (hier)

Was sind die Nachteile vom Screaming Frog?

Der größte Nachteil ist der Ressourcen-Verbrauch. Möchte man mit dem Screaming Frog große Websites (+500.000 URLs) crawlen, benötigt man einen leistungsstarken PC. Denn der SEO Spider wird lokal installiert. Crawl-Daten können bei wenig Arbeitsspeicher auch auf die HDD geschrieben werden (Database Storage), idealerweise eine SSD. Allerdings hat man das Problem bei der Verwendung von SaaS-Lösungen nicht, wie Audisto oder Sitebulb.

- Lokale Installation: Ressourcen-hungrig (Arbeitsspeicher/SSD)

- Für technisch erfahrene SEOs und Web-Entwickler geeignet

- Etwas sperrige Tabellenbasierte Benutzeroberfläche

Funktionsumfang vom Screaming Frog

- Defekte Links, Fehler und Weiterleitungen identifizieren

- Analyse von Seitentiteln und Metadaten

- Daten mit XPath extrahieren

- XML-Sitemaps generieren

- JavaScript-Webseiten crawlen

- Zeitplan für Audits

- Weiterleitungen (-schleifen) auswerten

- Duplizierte Inhalte ermitteln

- Integration mit GA, GSC und PSI

- Visualisierung der Site-Architektur

- Crawls miteinander vergleichen

- Überprüfung Meta Robots & Richtlinien

- XML-Sitemaps bewerten

- Validierung von strukturierten Daten

- Rechtschreib- und Grammatikprüfung

- Benutzerdefinierte Quellcode-Suche mit Massen-Upload-Funktion

- Benutzerdefinierte Extraktion

- Standard- und Formularbasierte Authentifizierung (Staging)

- Raw und gerendertes HTML speichern und vergleichen

- Individuelle robots.txt-Konfiguration (robots.txt Check)

- AMP Crawling & Validierung

- Flesch-Lesbarkeitsbewertung

- Mobile Benutzerfreundlichkeit über die Lighthouse-Integration prüfen

- Lokale Lighthouse-Integration

- Segmente für individuelle Seitentypen oder Prioritätsbereiche

- Direkte KI-API-Integration

- Überprüfung der Barrierefreiheit (Validierung mit AXE-Regelsatz für Barrierefreiheit)

- E-Mail-Benachrichtigung über die Fertigstellung von Crawls

- …

Zielgruppen

Vor allem technisch erfahrene Suchmaschinenoptimierer und Entwickler erhalten mit dem Screaming Frog alle Möglichkeiten, um ausführliche Website Audits zu erstellen.

Für Website-Betreiber und Marketing-Fachkräfte ohne technisches Verständnis sind die komplexen Konfigurationsmöglichkeiten und Berichte sicher etwas unübersichtlich. Es erfordert etwas Zeit, um die tabellenbasierte Nutzeroberfläche zu verstehen und zu konfigurieren, die Crawl-Konfiguration durchzuarbeiten und die Crawl-Daten richtig zu interpretieren.

Screaming Frog Modi

Bei der ersten Anwendung fragt man sich meist, wie der Screaming Frog funktioniert. Er bietet vier verschiedene Modi:

| Modus | Beschreibung |

| SEO Spider | Die beliebteste Funktion ist der SEO Spider-Modus, mit dem man eine URL als Ausgangspunkt für das Crawling festlegt. Das ist meist die Startseite einer Website. Der Screaming Frog spidert diese URL und folgt den Links im HTML-Code und weiterer Quellen entsprechend der Crawl-Konfiguration. Die gesammelten Daten werden in Tabellen und Diagrammen dargestellt. |

| Liste | Mit dem Liste-Modus wird eine URL-Liste gecrawlt. Sie wird als Excel-Datei importiert oder aus der Zwischenablage eingefügt. Damit kann man die HTTP-Statuscodes beliebiger URLs schnell ermitteln. |

| SERP | Der SERP-Modus bietet die Möglichkeit, die Länge vom Seitentitel und der Seitenbeschreibung zu bewerten. Beide Meta Tags sind wichtige Bestandteile vom SERP Snippet einer Seite. Es erfolgt kein Crawling. |

| Vergleichen | Der Vergleichen-Modus ermöglicht es, zwei Crawls miteinander zu vergleichen. Er bietet sich bei einem Relaunch an, um das Testsystem mit der live-Website zu vergleichen oder um Änderungen wichtiger Prüfkriterien vor und nach erfolgten Maßnahmen der Website zu vergleichen. |

SEO Spider Konfiguration

Das Konfigurationsmenü vom Screaming Frog bietet im SEO Spider (früher: Crawl-Modus) umfassende Einstellmöglichkeiten für den Crawl. Es ist empfehlenswert, ausreichend Zeit zu investieren. Viele Crawl-Einstellungen besitzen Tooltips, um die jeweilige Einstellung zu erklären.

| Konfiguration | Beschreibung |

| Spider | Im Spider-Menü werden grundlegende Einstellungen zum Crawl-Verhalten vorgenommen, welche Linktypen gecrawlt und gespeichert werden sollen. Man kann festlegen, welche Elemente und Daten während des Crawls extrahiert, gespeichert und analysiert werden sollen. Limits können individuell bestimmt werden, wie die Crawlanzahl und Crawltiefe. Wichtige Einstellungen zum Rendering können individuell eingestellt werden. |

| Inhalt | Hier kann man konfigurieren, wie SEO Spider den Inhalt der gecrawlten Seiten analysiert. Man kann den Inhaltsbereich individuell bestimmen, den Umgang mit Duplikaten festlegen und optional die Rechtschreib- und Grammatikprüfung aktivieren. |

| robots.txt | Hier kann man festlegen, ob die Anweisungen der robots.txt-Datei der Website ignoriert werden sollen bzw. wie die Daten ausgeschlossener Ressourcen in den Screaming Frog-Reports dargestellt werden sollen. Es ist möglich, eine temporäre robots.txt-Datei für den Crawl zu erstellen und die Anweisungen auf dem Webserver zu überschreiben. |

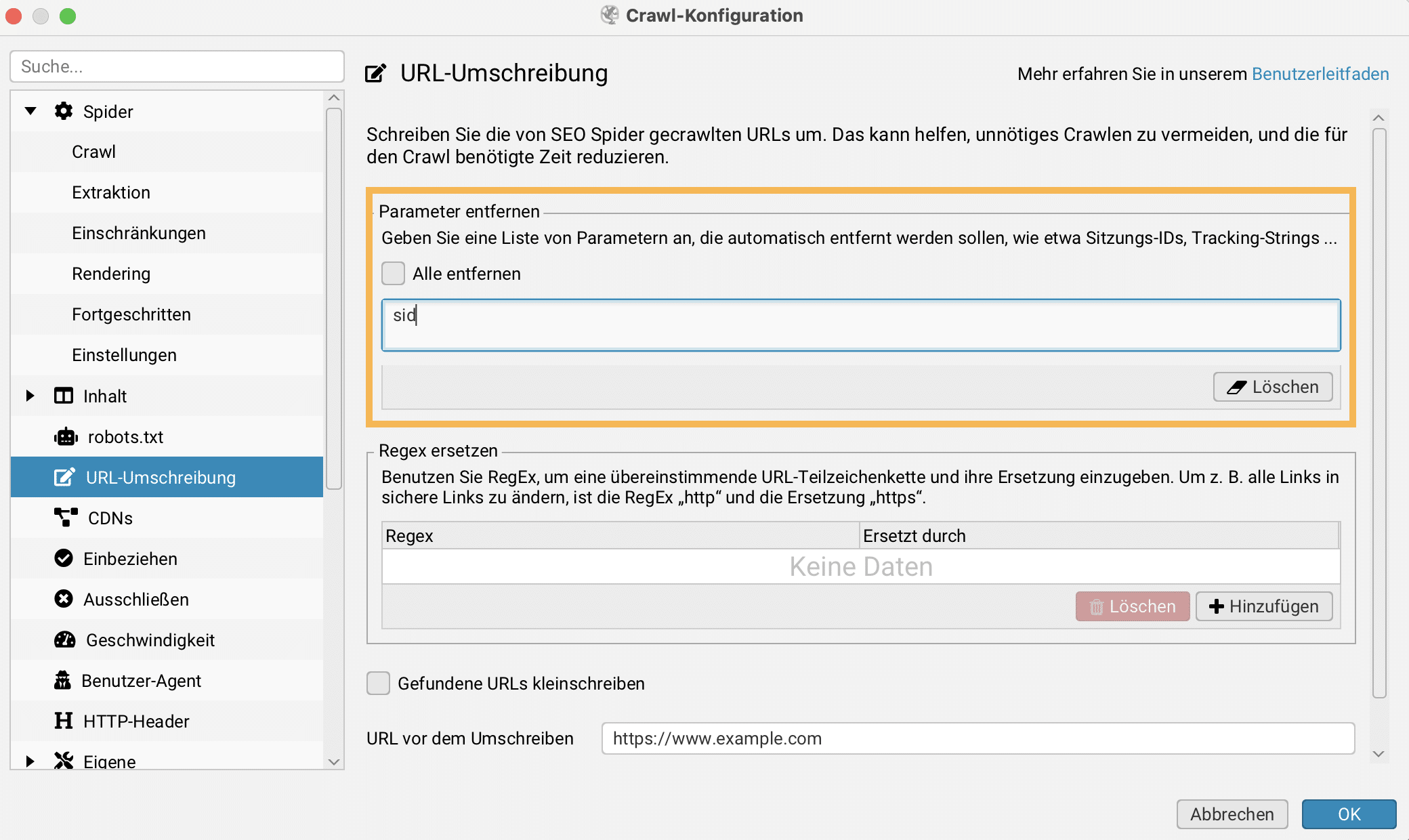

| URL-Umschreibung | Mit dieser Einstellung kann man die von SEO Spider gecrawlten URLs umschreiben. Das kann helfen, unnötiges Crawlen zu vermeiden und die Crawl-Zeit zu reduzieren. |

| CDNs | Werden verschiedene Ressourcen per CDN eingebunden, kann hier eine Liste von Subdomains und Verzeichnissen notiert werden, damit diese Ressourcen beim Crawlen erfasst und als intern betrachtet werden. |

| Einbeziehen | Hier können Regular Expressions für URLs definiert werden, die beim Crawling zu beachten sind. |

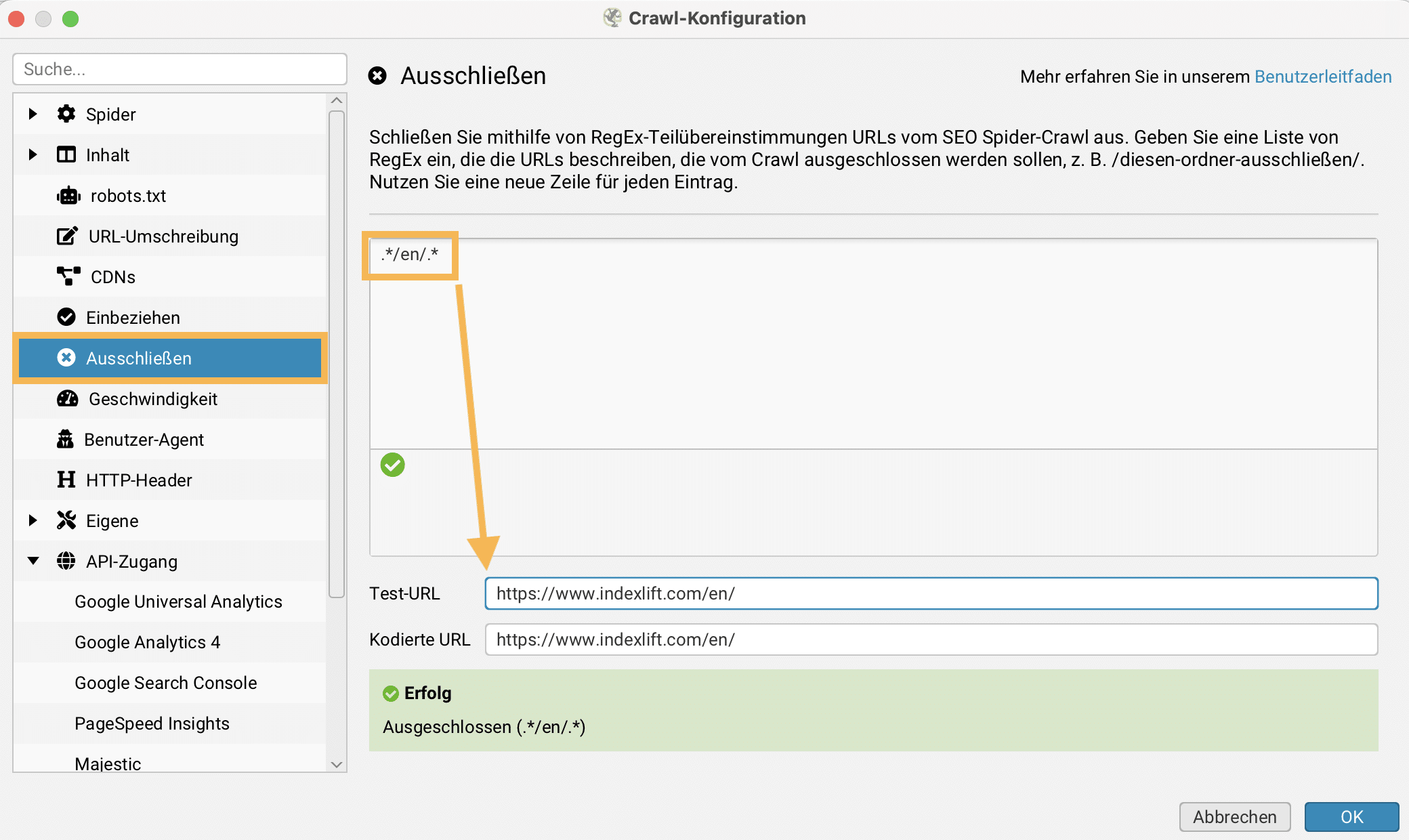

| Ausschließen | Hier können Regular Expressions für auszuschließende URLs festgelegt werden. |

| Geschwindigkeit | Diese Einstellungen konfigurieren die Geschwindigkeit der von SEO Spider gemachten Anfragen, entweder über die Anzahl gleichzeitiger Threads sowie über die Anzahl der URLs, die pro Sekunde angefragt werden. |

| Benutzer Agent | Hier kann man den User-Agent festlegen, den SEO Spider für den Crawl verwendet. Diese Einstellungen wirken sich auf die Robots-Anweisungen aus. |

| HTTP Header | Man kann die HTTP-Header anpassen, die SEO Spider für den Crawl verwendet. So können beliebige Header oder Werte angegeben werden – wie Accept-Language, Cookie, Referer. |

| Eigene | Eigene Suche ist eine einfache Suchfunktion im Quellcode von HTML Seiten oder PDFs. Damit können einfache Regular Expressions festgelegt werden.

Die Benutzerdefinierte Extraktion ermöglicht es, mithilfe von XPath, CSS-Pfad oder RegEx Daten aus internen HTML Seiten zu extrahieren. Außerdem können die Positionen von Links auf einer Seite definiert werden. Auch können eigene JavaScript-Snippets auf internen HTML-Seiten ausgeführt werden. |

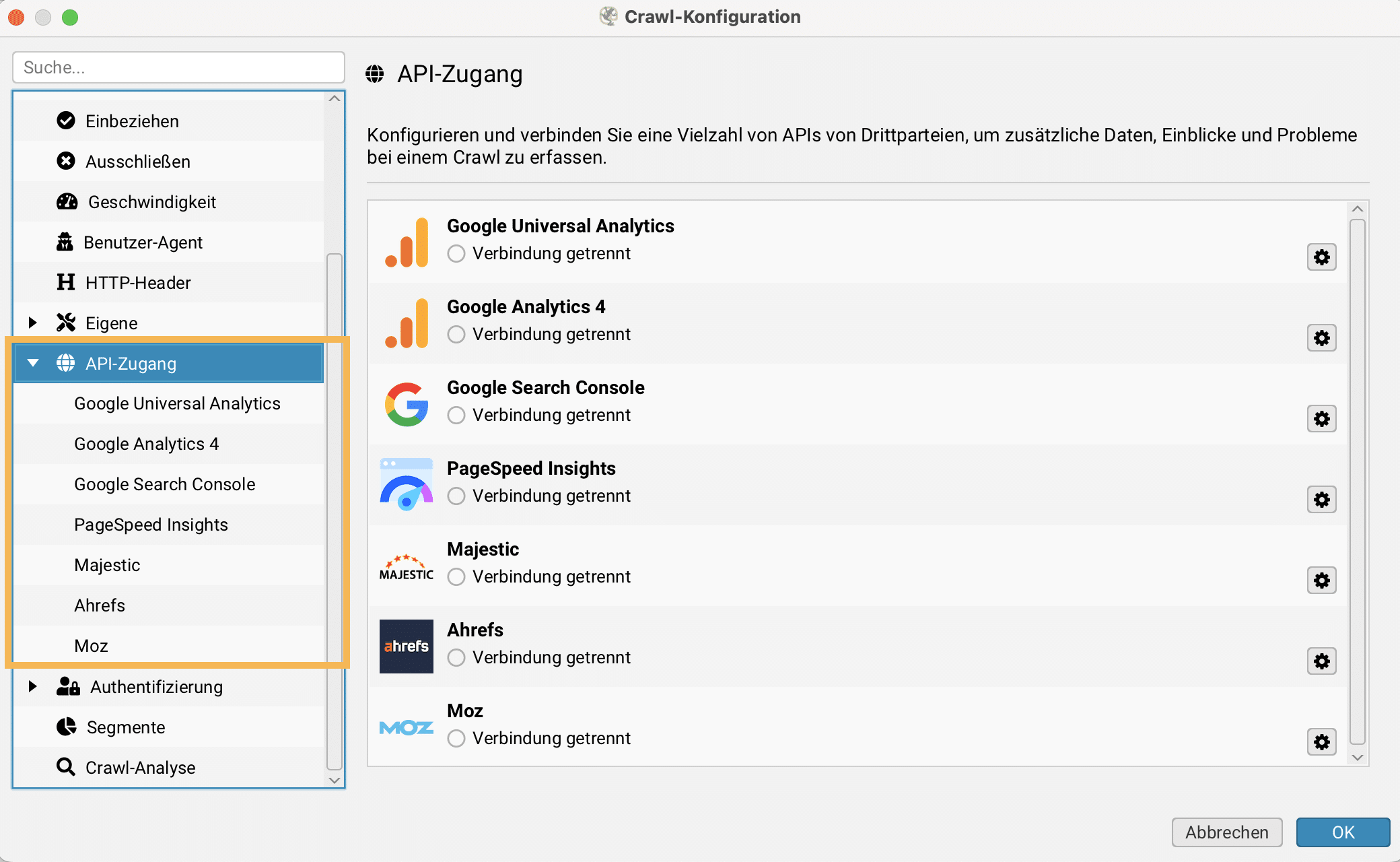

| API Zugang | Screaming Frog bietet Möglichkeiten, URL-Daten verschiedener Dienste per API zu beziehen und die URLs zu spidern: Google Universal Analytics, Google Analytics 4, Google Search Console, PageSpeed Insights, Ahrefs, Majestic, Ahrefs, Moz, OpenAI, Gemini, Ollama. |

| Authentifizierung | Geschützte Bereiche können mit Screaming Frog gespidert werden. Die Authentifizierung kann standardbasiert oder Webformular-basiert erfolgen. |

| Segmente | Durch eigene Segmente können Schwerpunktbereiche definiert werden. So können die Crawl-Daten individuell gefiltert und eingeschränkt werden. Ich finde Segmente für große Websites sehr hilfreich. |

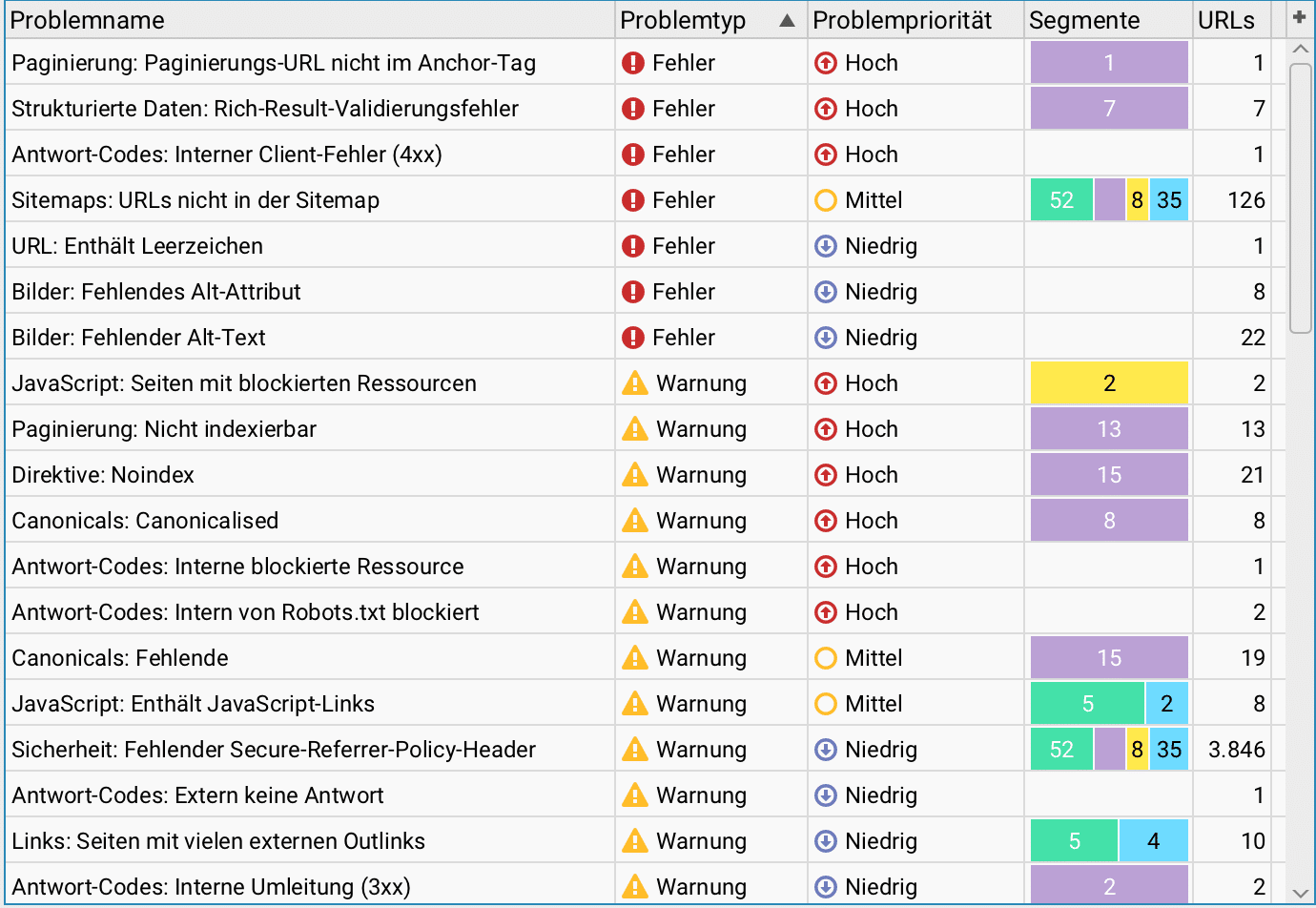

Probleme-Protokoll

Gut gelöst finde ich das Probleme-Protokoll, das eine Übersicht wichtiger Prüfkriterien liefert, um einen schnellen Überblick zu Problemen und Warnungen zu erhalten. Man öffnet es in der Reiter-Navigation Probleme vom Übersicht-Reiter.

Was ist der Übersicht-Reiter? Im Screaming Frog befindet sich der Übersicht-Reiter auf der rechten Seite und listet alle Prüfkriterien des Crawls auf. Durch Klicken auf ein Prüfkriterium öffnet man die jeweilige Datentabelle.

Visualisierungen: Crawlbaumgraph

Screaming Frog bietet verschiedene Visualisierungen für eine gecrawlte Website an. Den Crawlbaumgraph finde ich am hilfreichsten, um die Website-Architektur zu visualisieren.

Der Crawlbaumgraph zeigt an, wie der SEO Spider eine Website gecrawlt hat, und zwar nach dem kürzesten Pfad zu einer Seite von der Start-URL. Er zeigt nicht jeden internen Link, weil das die Visualisierungen schwer skalierbar und unverständlich machen würde. Wenn eine Seite mehrere Links aus der gleichen Tiefe besitzt, wird derjenige Link angezeigt, der zuerst gecrawlt wurde. Die Crawl-Visualisierungen sind hierarchisch nach Crawl-Tiefe geordnet, und die Linien zwischen URLs stellen den kürzesten Pfad dar. Das macht den Crawlbaumgraph sehr nützlich für die Analyse der Website-Architektur und der internen Verlinkung.

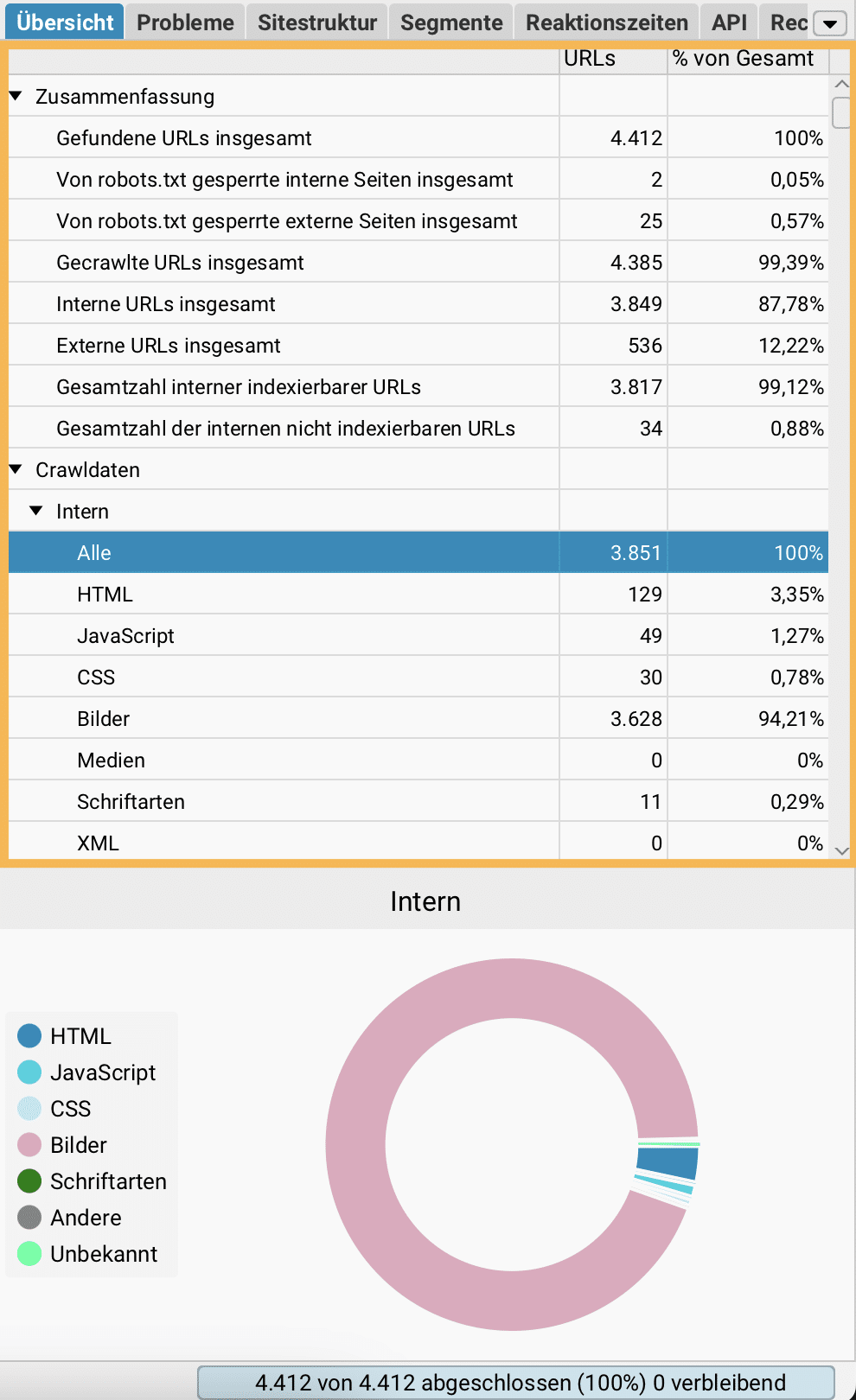

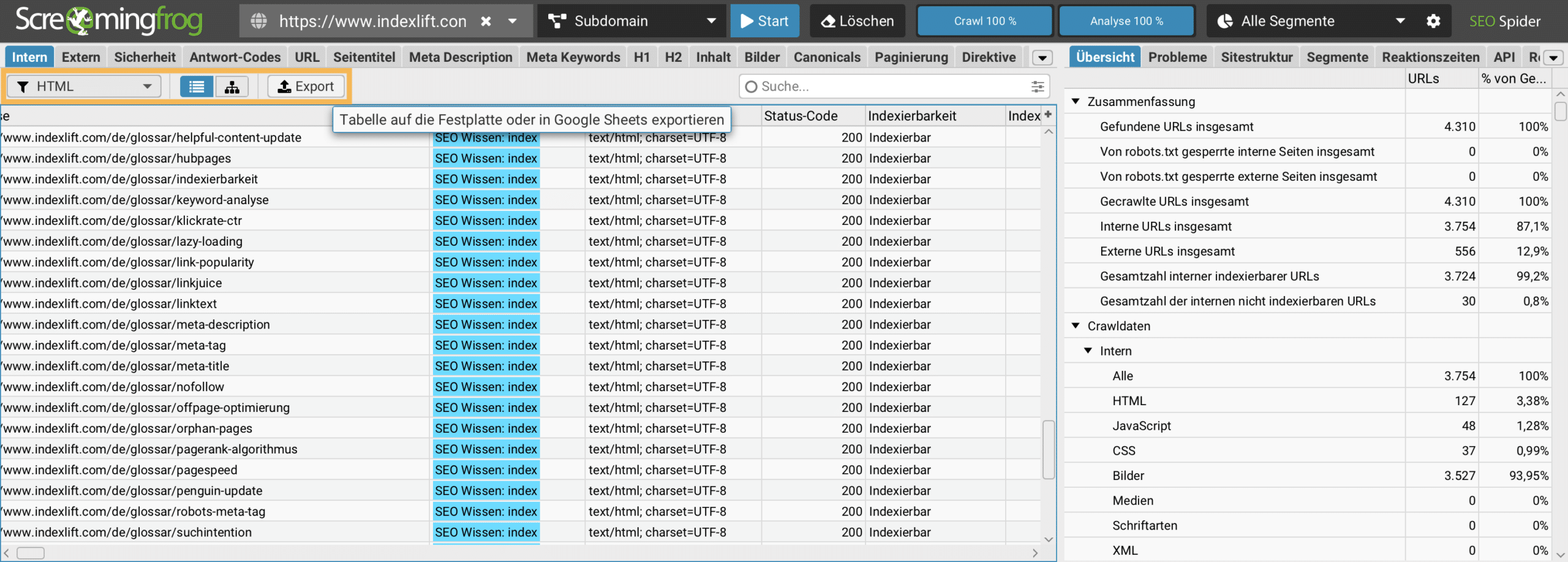

Berichte exportieren

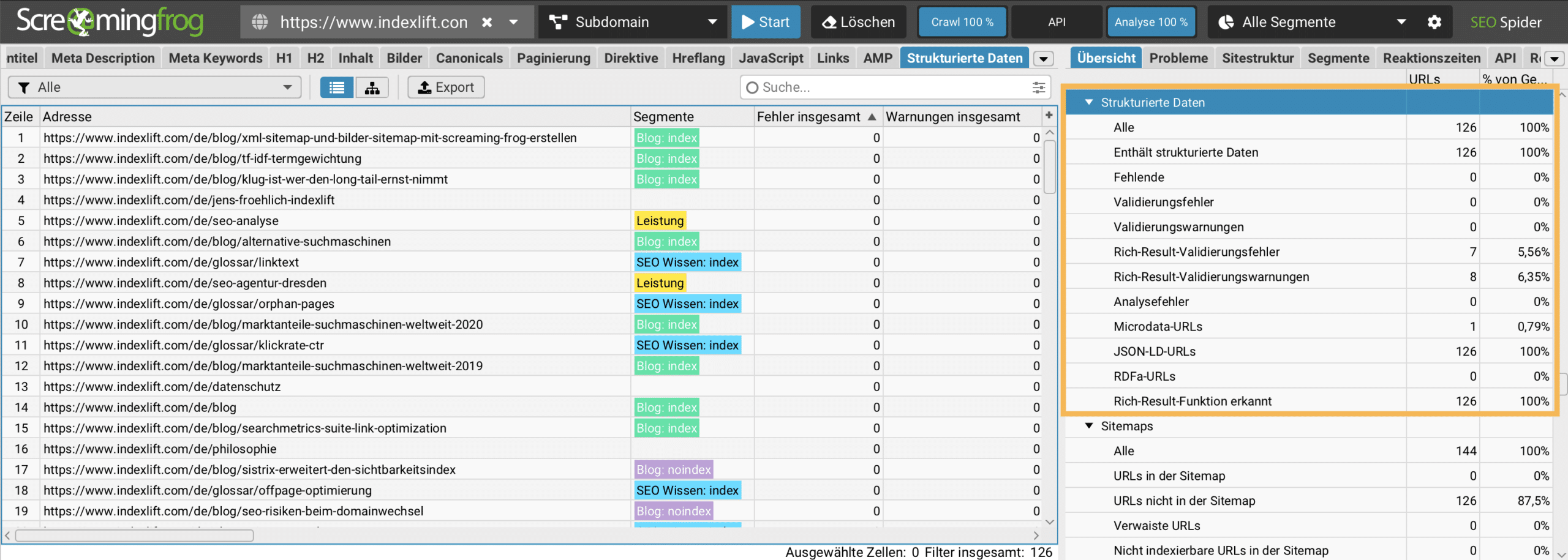

Sobald ein Crawl abgeschlossen ist, können alle Datentabellen exportiert werden. Dazu klickt man auf den Export-Button (oranger Rahmen im Screenshot), um alle Daten eines Berichts zu exportieren.

Massenexport

Analog zu den Reports können verschiedene vordefiniertes Massenexports erstellt werden, um die Crawl-Daten in Excel oder einem anderen Programm (Apple Numbers) weiter zu bearbeiten. Massenexports können im Hauptmenü aufgerufen werden.

🔥 Screaming Frog Anwendungstipps

- Nicht crawlbare URLs ermitteln

- Nicht indexierbare URLs ermitteln

- Interne Client-Fehler (4xx) ermitteln

- Canonicalized URLs nicht verarbeiten

- Insecure Content aufdecken

- Strukturierte Daten auswerten

- SERP Snippets optimieren

- Externe Dienste per API einbinden

- Orphan URLs ermitteln

- Testumgebung crawlen

- Interne Suche verwenden

- Include und Exclude Filter notieren

- Custom Extraction-Filter verwenden

- URL-Liste exakt crawlen (Listen-Modus)

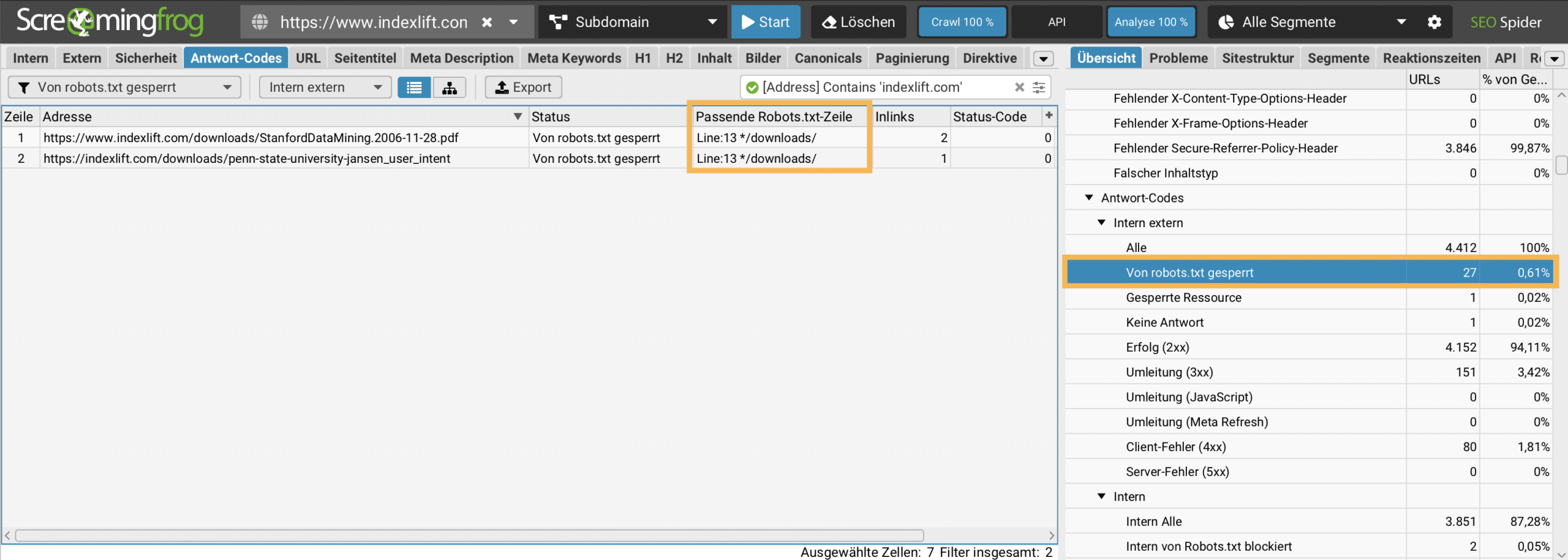

Nicht crawlbare URLs ermitteln

Bei jedem professionellen SEO-Audit wird die Crawlbarkeit interner URLs geprüft. Vor einem Website-Crawl empfehle ich eine Konfiguration zu wählen, dass die robots.txt-Anweisungen beachtet werden: Konfiguration > robots.txt > robots.txt respektieren auswählen. Die betreffenden URLs werden im Übersicht-Reiter Antwort-Codes > Von robots.txt gesperrt inkl. der Anweisung dokumentiert. Fehlkonfigurationen können somit schnell ermittelt werden.

Möchte man die robots.txt-Anweisungen auf dem Webserver überschreiben, ist das in den robots.txt-Einstellungen der Crawl-Konfiguration möglich. unter Eigene Robots werden die individuellen Anweisungen notiert. Diese Anweisungen kann man vor dem Crawling testen.

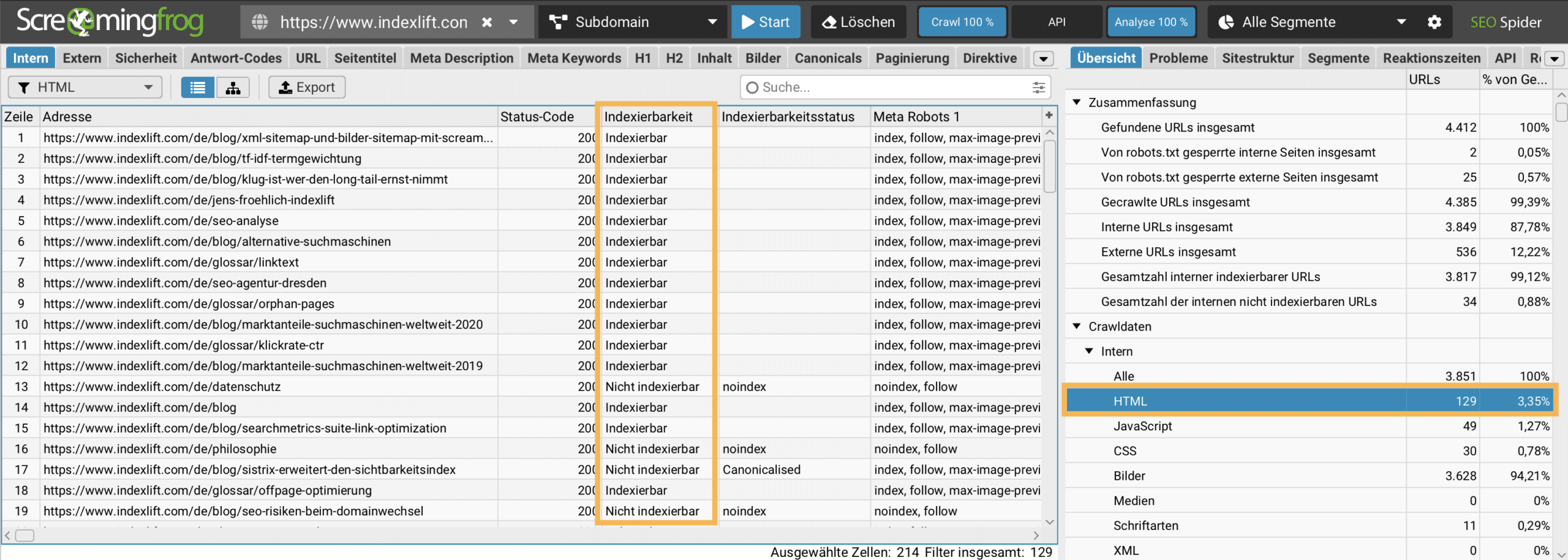

Nicht indexierbare URLs ermitteln

Alle crawlbaren URLs sollten bei einem SEO Audit bezüglich deren Indexierbarkeit analysiert werden, um zu ermitteln, ob relevante Seiten durch technische Fehlkonfigurationen (Meta Robots Tag/ Canonical Tag) vom Indexieren ausgeschlossen werden. Die Daten lassen sich im SEO Spider-Modus ermitteln.

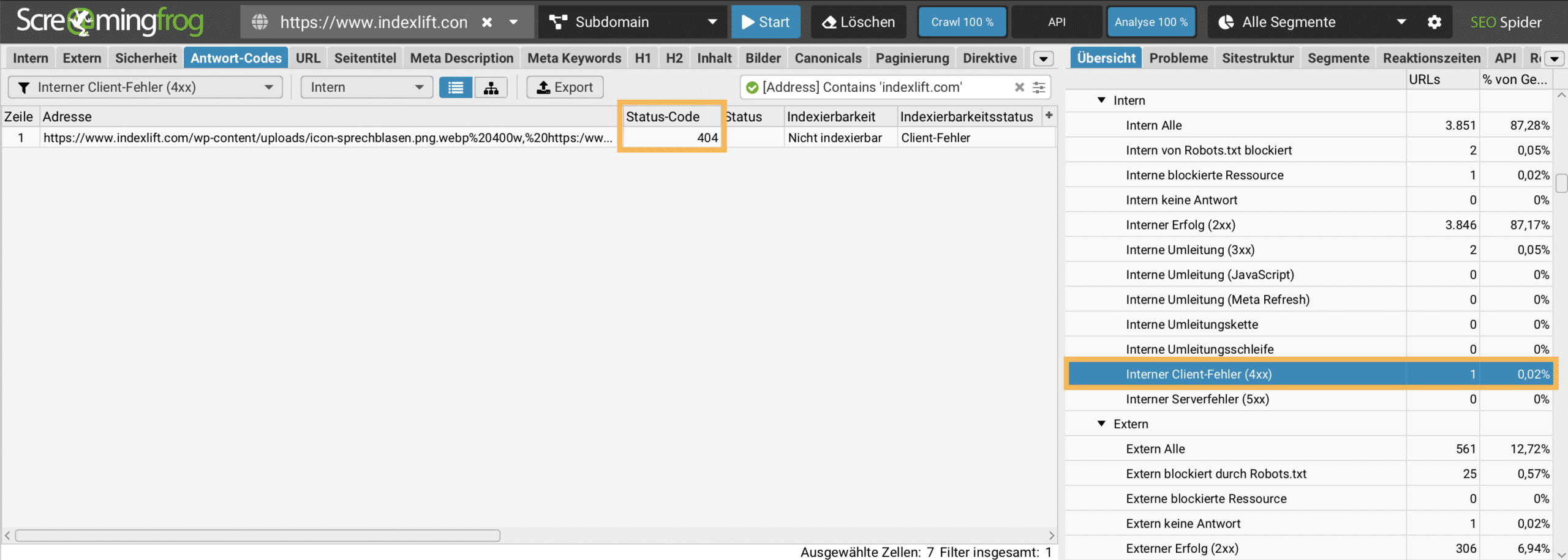

Interne Client-Fehler (4xx) ermitteln

Der Bericht Interne Client-Fehler (4xx) unter Antwort-Codes im Übersicht-Reiter listet alle URLs auf, die nicht verfügbar sind und einen HTTP Statuscode 4xx generieren. Auf diesen Seiten ist die Absprungrate sehr hoch. Deshalb sollten interne Verlinkungsfehler vermieden werden. Bei jedem Crawling sollten diese Daten analysiert und Fehler korrigiert werden.

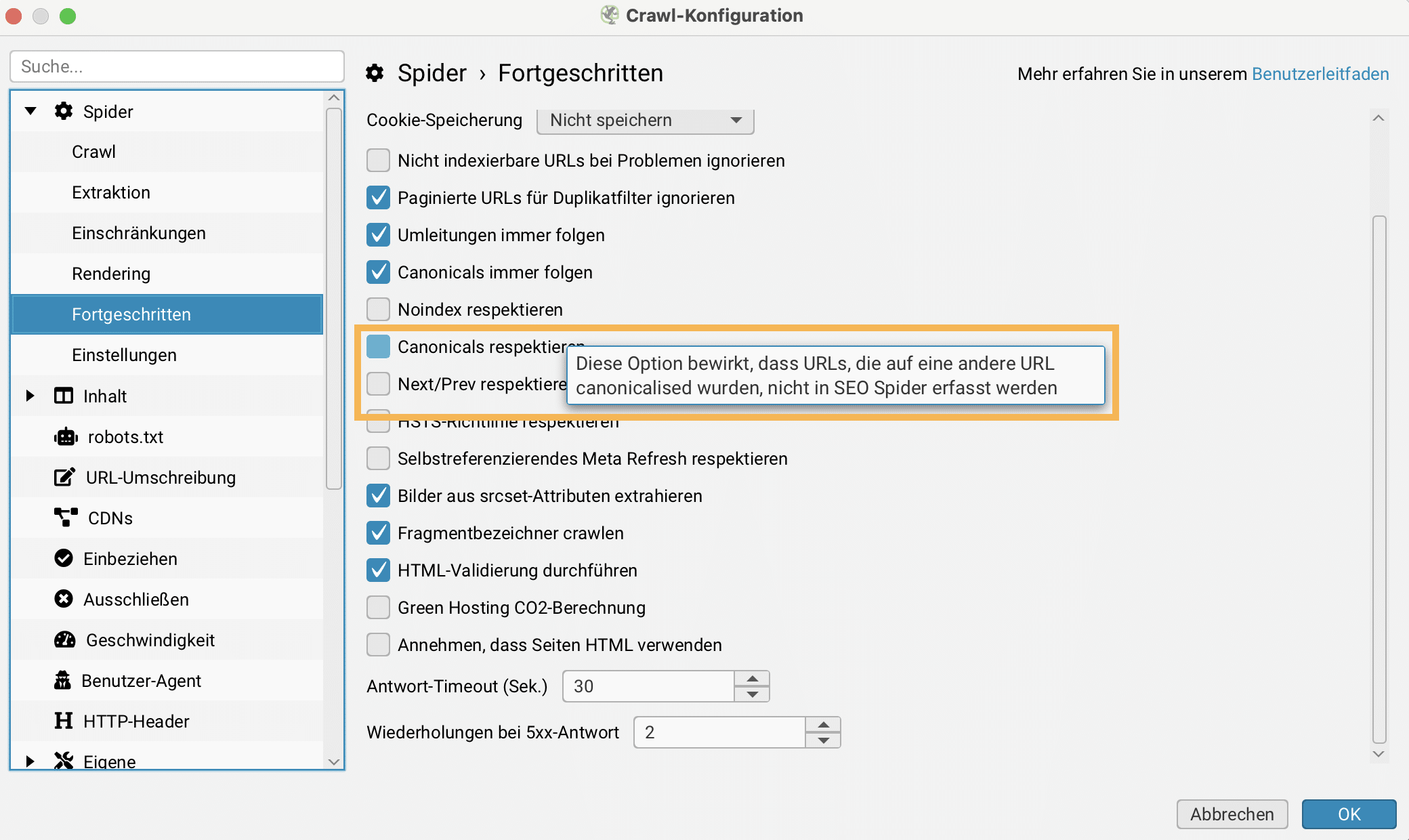

Canonicalized URLs nicht verarbeiten

Wenn große Websites gecrawlt werden und der Fokus auf indexierbaren URLs liegt, hilft die Funktion Canonicals respektieren – über Konfiguration > Spider > Fortgeschritten. Diese Einstellung bewirkt, dass URLs, die auf eine andere URL canonicalized sind, nicht in SEO Spider erfasst werden.

Sind alle Get-Parameter der Website bekannt, die aufgrund von Canonical Tags nicht gecrawlt werden sollen, bietet sich die Verwendung der Funktion URL-Umschreibung an. (Konfiguration > URL-Umschreibung > Parameter entfernen) Pro Zeile kann ein Parameter notiert werden, den der Screaming Frog beim Crawlen ignorieren soll. Ein Beispiel ist der Parameter ?sid= der oft in Shopware gesichtet wird. Sollen diese URLs beim Spidern nicht erfasst werden, dann braucht nur sid hinterlegt zu werden.

Insecure Content aufdecken

Dass HTTPS heute Standard für jede Website ist, sollte bekannt sein. Screaming Frog bietet einen Filter, um URLs zu identifizieren, die intern nicht per HTTPS verlinkt sind und korrigiert werden sollten. Dieser Filter befindet sich rechts im Overview unter Sicherheit > HTTP-URLs.

Strukturierte Daten auswerten

Seit Version 11 liest der Screaming Frog Structured Data aus. Diese Filter sind interessant, wenn der technische und OnPage Optimierungsgrad der Website hoch ist, keine internen Fehler bestehen, Seitentitel, Seitenbeschreibung, Headlines und Images optimiert sind und natürlich die Indexierungslogik optimal ausgerichtet ist.

Die Strukturdaten sind im Übersicht-Reiter unter Strukturierte Daten zu finden. Besonders hilfreich sind die Filter, um Validierungsfehler und Warnungen zu ermitteln.

SERP Snippets optimieren

SERP Snippets sind der erste Kontaktpunkt mit dem Suchmaschinen-Nutzer. Deshalb sollten wichtige Seiten einen optimalen Seitentitel und eine optimale Seitenbeschreibung erhalten. Mit dem Screaming Frog lassen sich diese Daten schnell auswerten. Ich verwende dafür gern den Bericht Intern > HTML im Übersicht-Reiter.

In der unteren Reiter-Navigation befindet sich unter SERP-Ausschnitt ein SERP Snippet Tool, mit dem der Seitentitel und die Seitenbeschreibung einer Seite bewertet werden kann. Man kann temporär ein besseres SERP Snippet erstellen und verschiedene Darstellungen testen.

Externe Dienste per API einbinden

Screaming Frog kann im SEO Spider-Modus API-Daten von externen Diensten einbinden: Google Universal Analytics, Google Analytics 4, Google Search Console, Ahrefs, Majestic und Moz. Jeder Dienst muss verifiziert werden.

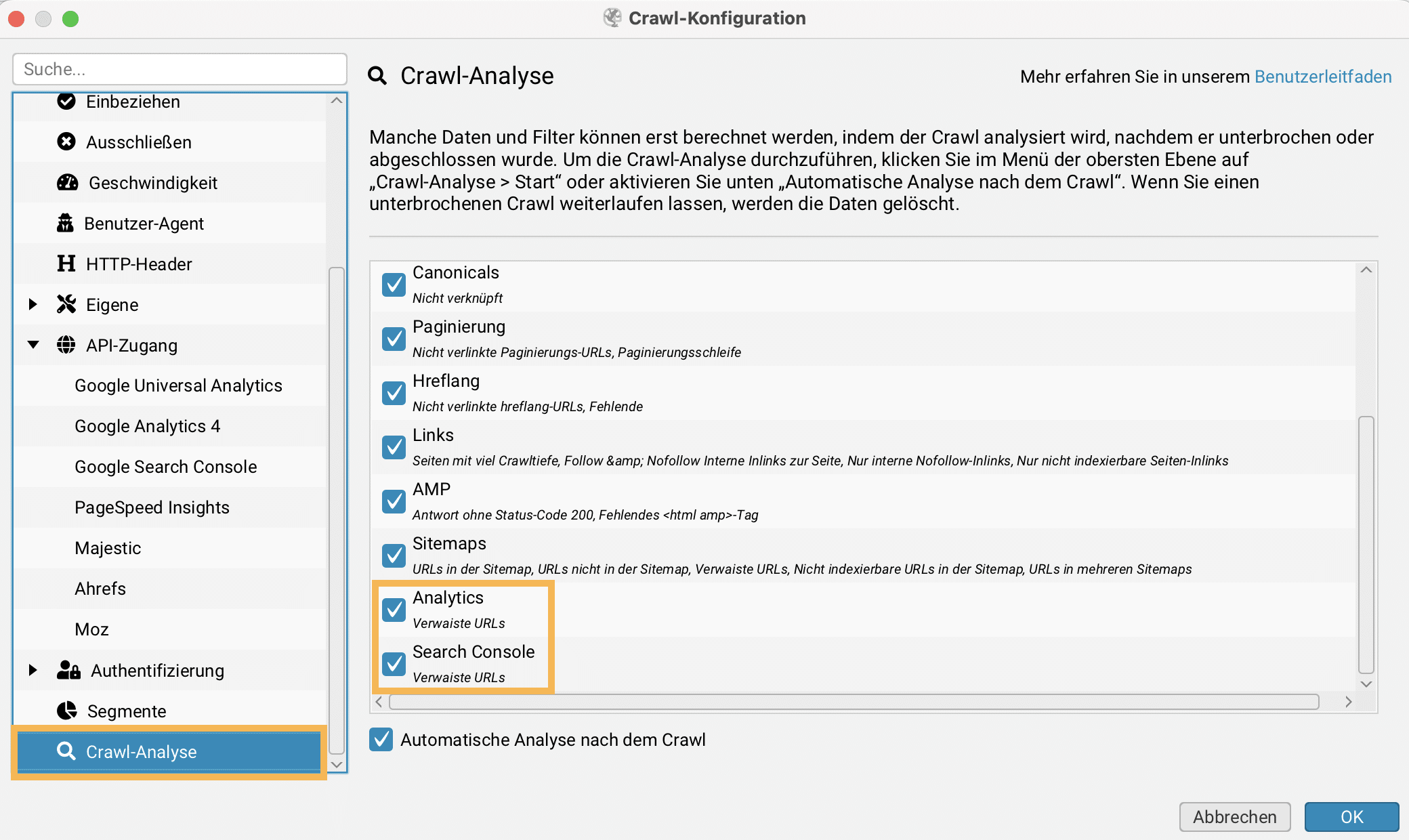

Orphan URLs ermitteln

Als Orphan URLs (Verwaiste Seiten) werden in der Suchmaschinenoptimierung Seiten bezeichnet, die durch eine schlechte interne Verlinkung nicht von Suchmaschinen-Bots gefunden und nicht verarbeitet werden können. Mit Screaming Frog SEO Spider können Orphan URLs enttarnt werden. Voraussetzung hierfür ist die Verwendung der Google Analytics-API oder der Search Console-API, sowie nach dem abgeschlossenen Crawl die Durchführung einer Crawl-Analyse.

Testumgebung crawlen

Mit Screaming Frog SEO Spider können geschützte Testumgebungen (Standardbasiert oder Formularbasiert) gecrawlt werden. Die Zugangsdaten gibt man in der Crawl-Konfiguration unter Authentifizierung vor dem Crawling ein.

Interne Suche verwenden

Die interne Suchfunktion ist ein mächtiges Feature vom Screaming Frog SEO Spider. Hier können Daten gesucht werden, zum Beispiel alle Adressen, die einen bestimmten Begriff besitzen. Im Suchfeld können sogar reguläre Ausdrücke (Regular Expression) verwendet werden – ein paar Beispiele:

| Regulärer Ausdruck | Haken bei | Funktion |

| .html$ | Address | Alle URLs, die mit .html enden |

| (?i)LTE(?-i) | Address | Alle URLs mit dem regulären Ausdruck LTE (Großbuchstaben) |

| ^4 | Status Code | Alle URLs, deren Statuscode mit 4 beginnt |

Include und Exclude Filter notieren

Include Filter eignen sich immer dann, wenn bestimmte Teilbereiche einer Website gecrawlt werden sollen. Angenommen eine Website wird in mehreren Sprachen bereitgestellt. Jede Sprachversion befindet sich in einem Verzeichnis (z. B. /de/ und /en/ und /fr/). Soll nur eine bestimmte Sprachversion der Website untersucht werden, hinterlegt man vor dem Crawling einen Include-Filter – zum Beispiel für das Verzeichnis /de/.

Im Gegensatz können für einen Crawl auch Exclude-Filter definiert werden, sodass bestimmte URLs und Verzeichnisse beim Crawlen ignoriert werden. In meinem Beispiel werden alle URLs mit dem Pfad /en/ ignoriert. Es können mehrere Excludes festgelegt werden. Pro Zeile wird ein Exclude-Filter notiert.

Custom Extraction-Filter verwenden

Durch Custom Extraction Filter können individuelle Filter für einen Crawl definiert werden. Diese mächtige Funktion befindet sich im Hauptmenü unter Konfiguration > Eigene > Benutzerdefinierte Extraktion. Wer technisch erfahren ist, kann sehr hilfreiche Filter erstellen.

Die Daten werden im Übersicht-Reiter unter Benutzerdefinierte Extraktion > bereitgestellt.

URL-Liste exakt crawlen (Listen-Modus)

Soll eine URL-Liste gecrawlt werden, bei der ausschließlich die angegebenen URLs gecrawlt werden sollen, dann hilft folgender Tipp:

- Listen-Modus auswählen

- File > Configuration > Clear Default Configuration

- Upload auswählen und URL-Liste hochladen oder aus Zwischenablage einfügen

- Start

Clear Default Configuration löscht alle individuellen Konfigurationen. Zuvor sollte ein Backup der eigenen Default-Settings erfolgen: File > Configuration > Safe As…

Screaming Frog Alternativen

Für mich ist Screaming Frog SEO Spider nahezu der perfekte Website Crawler. Einzig die lokale Installation und das sperrige Tabellenlayout dämpfen die Nutzerzufriedenheit ein wenig. JavaScript Crawling und Rendering, Export-Möglichkeiten, Funktionsumfang und die Möglichkeit Millionen von URLs zu crawlen machen den Screaming Frog fast konkurrenzlos. Empfehlenswerte Alternativen, die ich mit einem guten Gefühl empfehlen kann, sind: Ahrefs Site Audit Tool, Sitebulb und Audisto Crawler.

Kommentar verfassen