Bereits mehrfach habe ich Audisto Crawler für tiefgreifende Websites Audits verwendet. Denn der robuste Cloud Crawler überzeugt in vielen Perspektiven. Leider verarbeitet und rendert er noch kein JavaScript. Überzeugt Audisto Crawler trotzdem und ist er für tiefgründige Website Audits empfehlenswert? Hier erfährst Du alles Wissenswerte über den Website Crawler aus dem Hause Audisto.

Inhaltsverzeichnis

Was ist der Audisto Crawler?

Der Audisto Crawler ist ein SEO Onpage-Crawler zur Analyse von Fehlermustern, zur schnellen Identifizierung technischer Probleme und für datengestützte Entscheidungen über Website-Verbesserungen. Zielgruppen sind meines Erachtens technisch erfahrene SEOs und Webmaster, sowie Web-Entwickler.

Wichtige Funktionen für Website Audits

- Skalierbarer Cloud Crawler Software für die Verarbeitung bis zu +50 Millionen URLs

- Professionelles Crawling-Tool für Onpage-, Content- und Strukturanalysen

- Crawling mit bis zu 24 parallelen Threads

- Analyse von Fehlermustern in Code und Vorlagen zur Ermittlung technischer Probleme

- Detaillierte Berichte, um Trends zu erkennen und Fehlkonfigurationen zu beheben

- Crawlability-Analyse

- Analyse der Linkstruktur auf der Website

- Indexierbarkeits- und Noindex-Checker

- Test von hreflang-Tags und Sprachdefinitionen

- Aufspüren von Duplicate Content

- Domain-übergreifendes Crawling mehrerer Websites

- Automatisierte technische Website-Audits

- Vollständige Daten-Exporte

- Historische Trenddaten für alle KPIs, Hinweise und Zustände für regelmäßige automatisierte Crawls

- Eine Overload Protection drosselt das Crawling, wenn zu viele Fehler auftreten

Audisto Bewertung

Audisto Crawler ist für das Crawling von großen Websites empfehlenswert. Viele Alternativen besitzen ein Limit (zum Beispiel Sitebulb mit 500,000 URLs pro Audit). Umfangreiche Projekte könnten dadurch nicht vollständig gecrawlt werden, was zu Fehlbewertungen der Crawldaten führen kann. Wenn die Verarbeitung und das Rendering von JavaScript in Deinem Projekt nicht wichtig ist, dann ist der Audisto Crawler eine Empfehlung für ein Audit Deiner Website. Doch leider ist JavaScript ein großer Flaschenhals, den man nicht unter den Teppich kehren kann und sich auf meine Gesamtbewertung auswirkt.

| Gesamt | 3.5/5 | |

| Benutzerfreundlichkeit | 4/5 | |

| Funktionsumfang [1] | 3/5 | |

| Dokumentation (FAQ) | 4/5 | |

| Preis-Leistungs-Verhältnis | 4/5 | |

| Empfehlungswahrscheinlichkeit | 3.5/5 |

[1] Keine Verarbeitung und kein Rendering von JavaScript (Angular, React, …)

Audisto Crawler Preise

Das Audisto-Preiskonzept finde ich fair und transparent. Denn für ein Crawling-Projekt bestimmt man die Anzahl der zu crawlenden URLs. Das erfolgt anhand eines skalierbaren Schiebereglers, mit dem man den Crawlumfang zwischen 100.000 und bis zu 50.000.000 crawlbare URLs festlegt. Der Crawl-Umfang bestimmt den Preis, beginnend ab 99,00 EUR bei monatlicher Zahlung. Im gebuchten Zeitraum können beliebig viele Projekt-Crawls durchgeführt werden, abhängig von der gebuchten Kapazität pro Crawl.

Möchte man den Audisto Crawler langfristig nutzen, bietet sich eine preisreduzierte jährliche Zahlung an. Vor allem empfehlenswert, wenn man regelmäßig automatisierte Website-Crawls durchführen möchte, siehe Crawl History.

Audisto Projekt konfigurieren

Die Konfiguration ist denkbar einfach. Zunächst bestimmt man den Crawl-Umfang für das Projekt und gibt anschließend den Startpunkt für das Crawling an. Es können auch mehrere Starting points festgelegt werden, zum Beispiel die Startseite der Website und eine XML-Indexdatei der Sitemaps.

- Crawl Speed Konfiguration (Parallel Downloads & Request Delay)

- Feinabstimmung des Verhaltens vom HTML- und HTTP-Header-Parser

- Robots.txt parsen oder durch custom robots.txt-Anweisungen überschreiben

- Connection Handling (HTTP 1.1 vs. HTTP 1.1 with connection reuse support)

- SSL Certificate Handling (Relaxed vs. Strict)

- Vordefinierte Cookies festlegen, die mit jeder Anfrage gesendet werden

- Vordefinierte HTTP-Header festlegen, die mit jeder Anfrage gesendet werden

- HTTP-Authentifizierung (Benutzer und Passwort für die HTTP-Authentifizierung)

- Erstellen individueller URL Normalization-Regeln

- Erstellen individueller URL Rewriting-Regeln

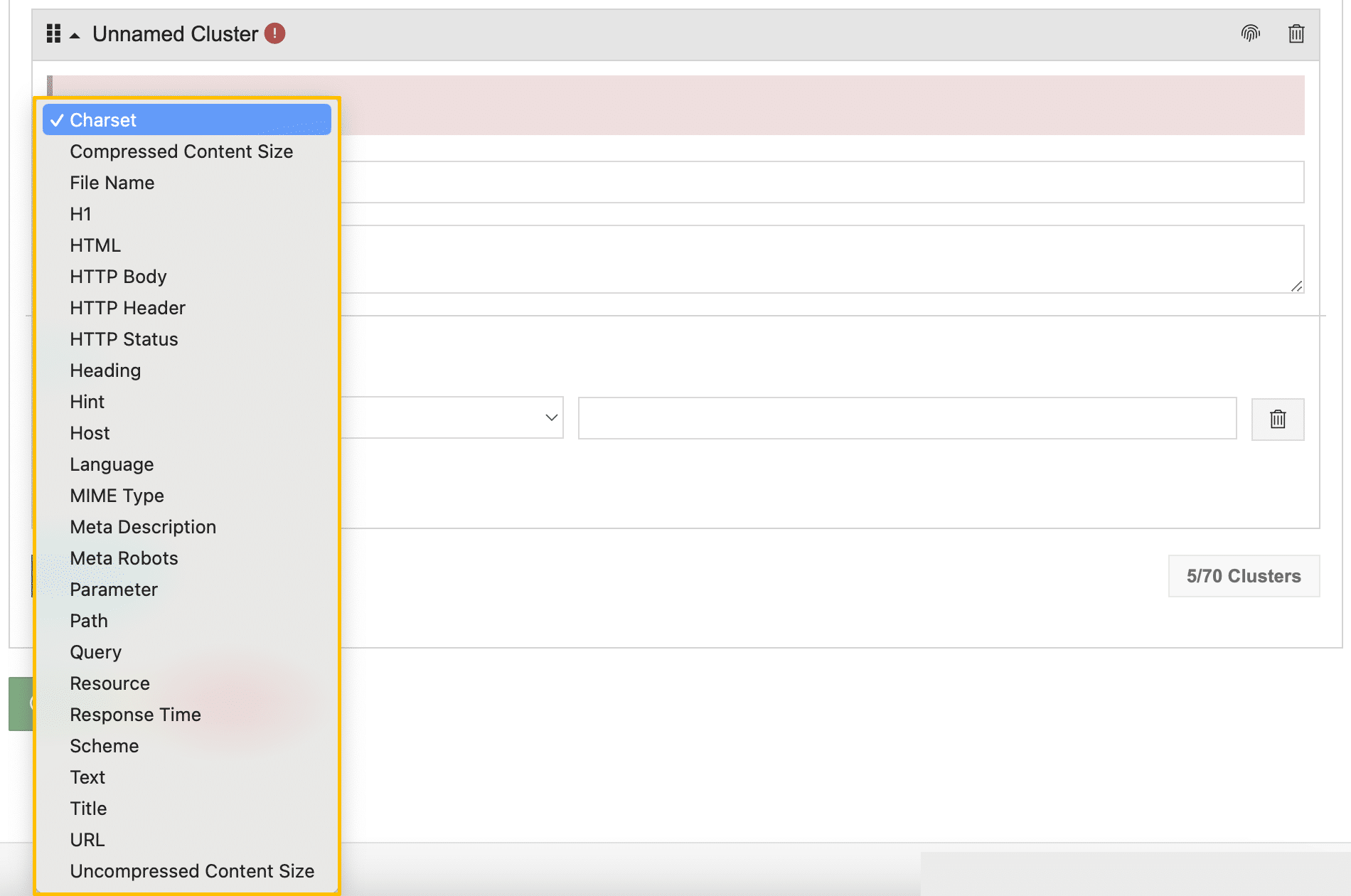

- Definition von Clustern als Filter für Crawl-Berichte

Current Crawl

Crawl Report

Der Crawl Report ist übersichtlich gestaltet und liefert eine Übersicht wichtiger SEO-Kennzahlen. Man erhält ein erstes Gefühl über den Optimierungszustand der Website. Ich finde den Crawl Report gut gelöst.

Schwerpunkte vom Crawl Report

- Crawl Details: URLs Crawled, URLs Analyzed, Links Analyzed, Time Spend

- Status: Crawled, Robots.txt Excluded, Not HTML, External URL

- HTTP Response Status Code

- Indexability of HTML Documents: Indexable, Robots Noindex, Canonical Link

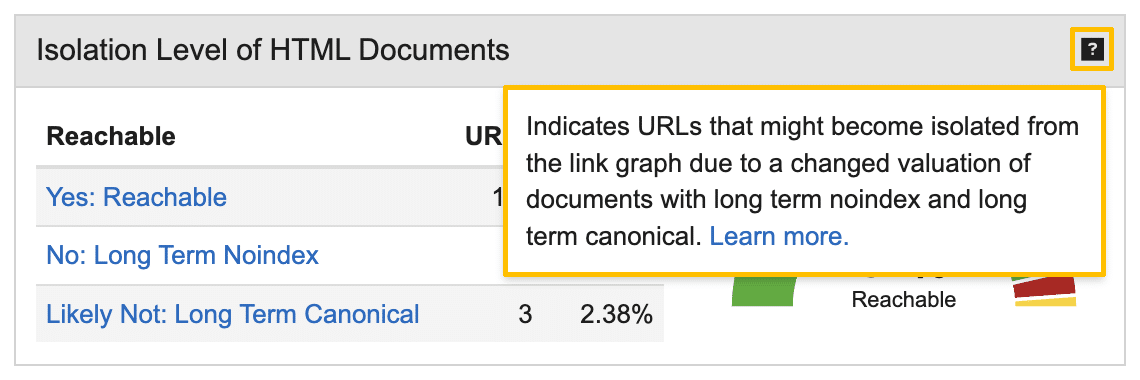

- Isolation Level of HTML Documents: Reachable, Long Term Noindex, Long Term Canonical

- Crawled Level

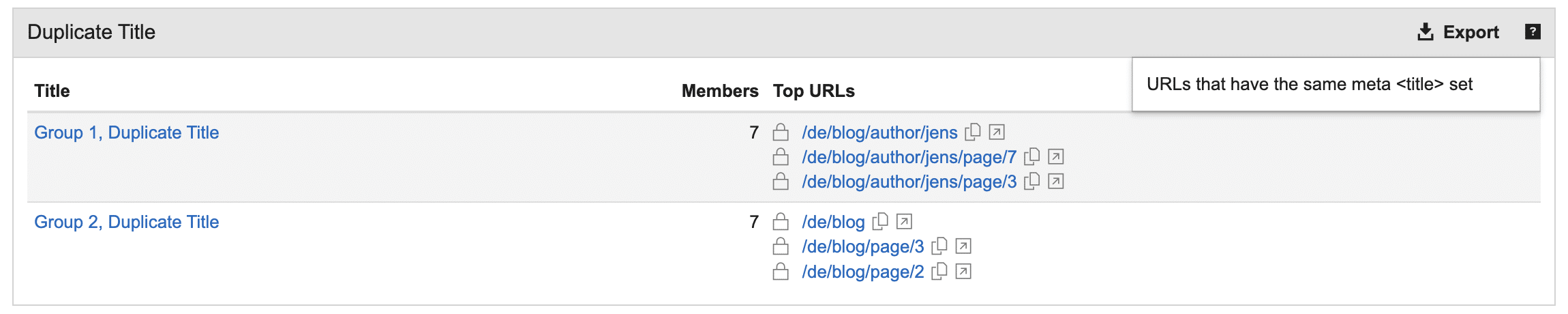

- Duplicate Content: Title, Meta Description, Page Body, Similar URLs

- Host Statistics

- Content Type

Crawler Berichte

Jeden Bericht einzeln vorzustellen, würde diesen Beitrag überladen. Deshalb liste ich hier die wichtigsten Berichte auf.

| Current Crawl | Enthaltene Berichte |

| Crawl Info | Starting Points, Errors, Logs, Scripting Issues, Robots.txt, URL Rewrites |

| Structure | Clusters, Levels, Hosts, Links, External URLs, Similar URLs |

| Performance | Response Times, File Sizes |

| On-page | Hints, Duplicate Content, Localization, Content Types, Hreflang |

| Ranks | Pagerank, Cheirank, 2D-Rank, Potentials |

Persönliche Eindrücke

Fehlende Filter und Sortierung

Die Berichte vom Audisto Crawler basieren auf Diagrammen und Datentabellen. Ich finde sie übersichtlich, doch oft funktional zu stark reduziert. Denn im Vergleich mit anderen Crawling Tools stellt Audisto keine Filter bereit, um Tabelleninhalte einzuschränken. Die Spaltensortierung kann man auch nicht ändern. Damit man die Crawldaten bearbeiten kann, muss man sie exportieren und in einer Tabellenkalkulation öffnen.

Keine Handlungsempfehlungen

Audisto-Berichte formulieren keine Handlungsempfehlungen. Es gibt keine Anleitung, was zu tun ist, um den SEO-Optimierungsgrad der gecrawlten Website zu verbessern.

Doch Hinweise (Hints) liefern Einblicke zu technischen Fehlkonfigurationen und über SEO-Potenziale. Sie richtig zu interpretieren und geeignete Maßnahmen zu formulieren, ist Aufgabe des Nutzers. Das finde ich in Ordnung.

Tooltips sind hilfreich

Doch die Tooltips sind hilfreich. Leider sind sie nicht für jeden Bericht verfügbar. Es wäre nützlich, wenn alle Berichte einen aussagekräftigen Tooltip bereitstellen. Denn es fühlt sich gut an, wenn man ein Tooltip liest und weiß, dass man die Daten von einem Bericht richtig verstanden hat.

Cluster als Filter verwenden

Hilfreich können Cluster sein. Ich empfehle bei der Projekt-Konfiguration individuelle Cluster zu erstellen, weil sie in vielen Crawling-Berichten als Filter verfügbar sind. Leider gibt es bisher nicht sehr viele Filtermöglichkeiten zur Erstellung von Clustern. Es wäre nützlich, wenn mehr Filter bereitgestellt werden, zum Beispiel Canonical Tag is self und Canonical Tag points to another url.

Benutzeroberfläche ist etwas sperrig

Trotz der übersichtlichen und reduzierten Benutzeroberfläche klicke ich manchmal viele Audisto-Berichte durch, bis ich den Richtigen gefunden habe. Man muss sich wirklich Zeit nehmen und sich mit der Benutzeroberfläche und den Funktionen beschäftigen, um mit dem Tool warm zu werden. Aber das trifft für die meisten SEO Spider zu.

Zum Beispiel wollte ich alle Crawling-Daten für eine gewünschte Seite bewerten. Doch welcher Bericht stellt einen URL-Filter mit den gewünschten Daten bereit? Die Lösung ist Search URLs › URL Report im Crawl Report. Den Bericht finde ich allerdings sehr hilfreich. Es fehlt nur eine HTML-Ansicht mit Quellcode-Suche.

Gruppierungen verschaffen Übersicht

Nützlich finde ich die Gruppierung von Daten, um Hinweise schnell zu bewerten. Der Crawl Report liefert beispielsweise Hinweise über Duplicate Title. Ein Klick auf den Hint und die Daten werden gruppiert dargestellt. In meinem Beispiel werden die doppelten Meta Title durch paginierte Seiten einer logischen Sequenz erzeugt und sind in diesem Fall nicht relevant. Gruppierungen finde ich hilfreich.

Performance-Berichte ohne CWV

Die Performance-Berichte überzeugen mich nicht. Denn im Gegensatz zur Konkurrenz werden keine Core Web Vitals-Kennzahlen protokolliert. Das sollte verbessert werden. Denn Core Web Vitals sind wichtige Kennzahlen der Performance-Optimierung und gehören meines Erachtens in jedes technische Audit. Response Times und File Sizes bereit zu stellen, ist nicht ausreichend. Ergänzend bieten sich Performance-Analysen mit GTmetrix oder WebPageTest an.

Fehlender Page Explorer/ Link Explorer

Es kann erforderlich sein, alle gecrawlten URLs oder verarbeiteten Links nach speziellen Informationen zu filtern. Etwa um alle internen Seiten anzuzeigen, die nicht kanonisch sind und das Meta Robots-Attribut noindex ausgeben. Bei Audisto weiß ich nicht, ob und wie das geht. Es wäre hilfreich, wenn Audisto diese Funktionen bereitstellt. Andere Crawl Tools bieten derartige Advanced Filter, wie Ahrefs Site Audit Tool:

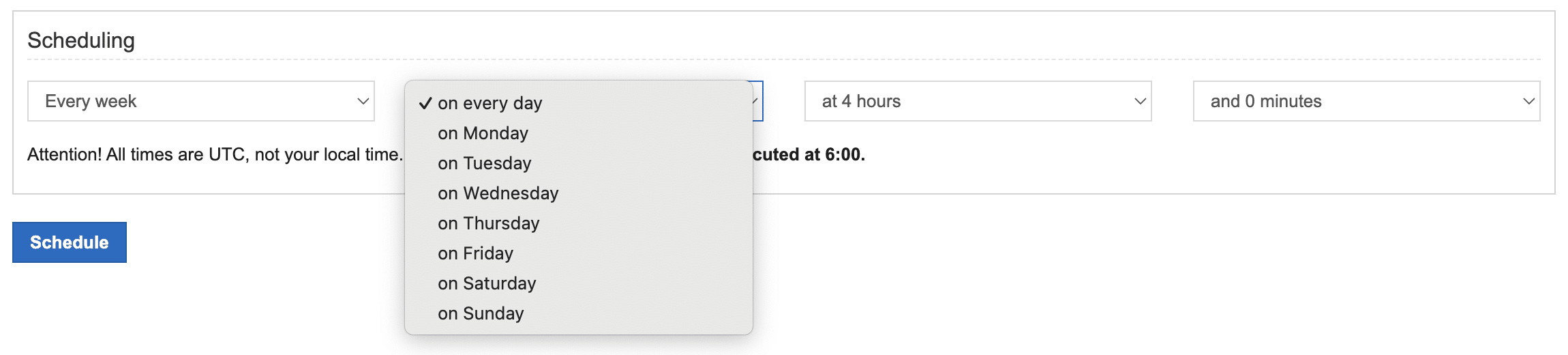

Crawl History

Audisto bietet die Möglichkeit, Crawls zu planen und automatisiert ausführen zu lassen. Diese Art von SEO-Controlling ermöglicht es, SEO-Trends zu erfassen und neue Projekt-Zustände aufzudecken. Das Crawling-Intervall kann individuell festgelegt werden, auch täglich.

Ich finde diese Funktion hilfreich und empfehle sie für jedes Projekt zu aktivieren. Denn die Crawl History stellt wichtige SEO-Erfolgsfaktoren übersichtlich in einem Dashboard bereit. So erhält man einen anschaulichen Überblick zu kurzfristigen Trends und über wichtige Website-Zustände. Tipp: Die Crawl History lohnt sich auch für eine Staging- oder Produktionsumgebung zu aktivieren, um beim Entwicklungsprozess aussagefähig zu sein und schnell eingreifen zu können.

Der Bericht Crawl History of Indexable ist beispielsweise hilfreich, um schnell zu erfassen, ob sich die Indexierbarkeit von Seiten, verglichen mit einem beliebigen vorherigen Crawl, verändert hat. Das finde ich visuell gut gelöst.

Audisto Monitoring

Ergänzend zum Audisto Crawler kann ein Audisto Monitoring gebucht werden. Dieses Tool ermöglicht automatisierte Website-Tests und technische SEO-Überwachung im großen Maßstab, um die Testabdeckung über jede einzelne Seite einer Website ohne Stichproben zu gewährleisten.

Features

- Sichern der Website-Elemente, um Konformität und Qualität zu erhalten

- Kritische Warnungen in Echtzeit

- Kontinuierliche Testabdeckung einschließlich vollständiger KPI-Historie

- Zeitersparnis für Qualitätsmanagement und Entwickler durch vollständig automatisierte Tests

- Crawler-basierte Überwachung ermöglicht Website-Tests auf Nutzerebene

- Automatisiertes SEO-Monitoring mit allen Funktionen des Audisto-Crawlers

- Handlungsfähige mehrstufige Überwachungs-Dashboards

- Schnelle Revisionen problematischer Änderungen

- Compliance-Warnungen für Produktseiten

- Kontinuierliche und automatische Alarmierung durch kritische Warnungen in Echtzeit und anpassbare Testintervalle

Preise

Audisto Monitoring basiert auf dem selben Konzept, wie der Audisto Crawler. Denn für ein Monitoring-Projekt bestimmt man die Anzahl der zu crawlenden URLs. Das erfolgt anhand eines skalierbaren Schiebereglers, mit dem man den Crawlumfang zwischen 100.000 und bis zu 50.000.000 crawlbare URLs festlegt. Der Umfang bestimmt den Preis, beginnend ab 649,00 EUR bei monatlicher Zahlung. Für längerfristige Projekte kann jährliche Zahlung mit Rabatt ausgewählt werden.

Kommentar verfassen